Люди упереджені щодо інших і це має реальні наслідки. Вам, наприклад, могли відмовити в прийомі на роботу лише тому, що ви не того знаку зодіаку, який подобається HR. З поширенням алгоритмів, які приймають рішення, дискримінації стало більше. Влада голландського міста Амстердам думала, що зможе зламати десятирічну тенденцію впровадження дискримінаційних алгоритмів. Але експеримент провалився, що піднімає питання: чи можуть ці програми коли-небудь бути справедливими?

Ханс де Цварт, вчитель фізкультури, який став захисником цифрових прав, каже, що коли він побачив план Амстердама щодо впровадження алгоритму оцінки кожного претендента на отримання соціальної допомоги в місті на предмет потенційного шахрайства, він мало не впав зі стільця.

Був лютий 2023 року, і де Зварт, який обіймав посаду виконавчого директора Bits of Freedom, провідної неурядової організацієї Нідерландів щодо захисту цифрових прав, майже два роки працював неофіційним радником міського уряду Амстердама, аналізуючи системи штучного інтелекту, які воно розробляло, і надаючи відгуки про них.

Згідно документації міста, ця конкретна модель штучного інтелекту, звана “Розумною перевіркою” (Smart Check), буде розглядати заявки від потенційних одержувачів соціального забезпечення і визначати, хто, можливо, подав неправильну заяву. За його словами, цей проект виділявся більше, ніж будь-який інший, і не в хорошому сенсі цього слова.

“Є деякі дуже фундаментальні [і] непереборні проблеми”, – говорить він, використовуючи цей алгоритм на реальних людях.

Зі свого спостережного пункту за широкою аркою скляних вікон в мерії Амстердама Пол де Конінг, міський консультант, в резюме якого значаться відвідування різних агентств соціальної допомоги голландської держави, з гордістю розглядав ту ж систему. Де Конінг, який керував пілотним етапом Smart Check, був у захваті від того, що він побачив в потенціалі проекту з підвищення ефективності та усунення упередженості в системі соціальних виплат Амстердама.

Команда дослідників шахрайства і спеціалістів по обробці даних витратила роки на розробку Smart Check, і де Конінг вважав, що багатообіцяючі ранні результати виправдали їх підхід. Місто консультувалося з експертами, проводило тести на упередженість, впровадило технічні заходи і запросило зворотний зв’язок від людей, яких програма торкнеться, більш або менш дотримуючись всіх рекомендацій у посібнику етичного використання штучного інтелекту.

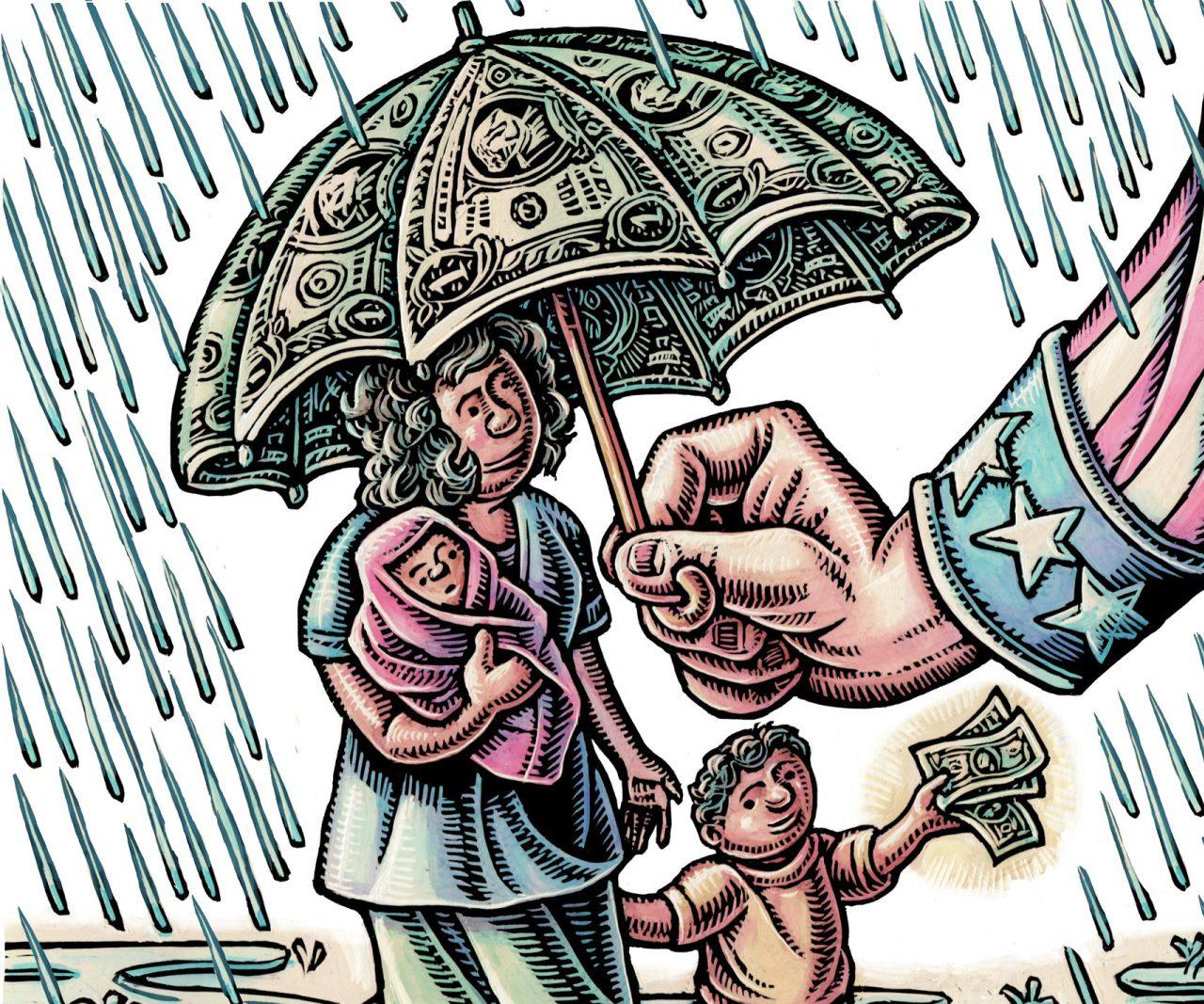

Ці протилежні точки зору втілюють глобальну дискусію про те, чи можуть алгоритми коли-небудь бути справедливими при прийнятті рішень, що визначають життя людей. За останні кілька років спроб використовувати штучний інтелект таким чином стало більше прикладів супутнього збитку: небілих претендентів виключили з пулу заявок на роботу в США , сім’ї були помилково зазначено для розслідувань жорстокого поводження з дітьми в Японії, а жителям з низьким доходом відмовили в субсидії на харчування в Індії.

Прихильники цих систем оцінки стверджують, що вони можуть створити більш ефективні державні послуги, роблячи більше з меншими витратами, і, зокрема, у випадку систем соціального забезпечення, повертати гроші, які губляться з державного гаманця.

На практиці багато з систем з самого початку були погано розроблені. Іноді вони враховують особисті характеристики таким чином, що призводять до дискримінації, а іноді їх застосовували без перевірки на упередженість або ефективність.

В цілому, вони пропонують людям мало можливостей оскаржити або навіть зрозуміти автоматизовані дії, що безпосередньо впливають на те, як вони живуть.

Результатом стали більш ніж десятирічні скандали. У відповідь законодавці, бюрократи і приватний сектор, від Амстердама до Нью-Йорка, від Сеулу до Мехіко, намагаються придумати щось, створюючи алгоритмічні системи, інтегруючі принципи “відповідального ШІ” — підходу, що направляє розвиток ШІ на благо суспільства при мінімізації негативних наслідків.

Розробка та впровадження етичного штучного інтелекту є головним пріоритетом для Європейського союзу, і те ж саме було вірно для США. Системи, засновані на цих принципах, володіють величезною владою приймати рішення, наприклад, кого наймати, коли розслідувати випадки потенційного жорстокого поводження з дітьми і які жителі повинні отримати послуги в першу чергу.

Амстердам дійсно вважав, що знаходиться на правильному шляху. Міські чиновники з департаменту соціального забезпечення вважали, що вони можуть створити технологію, яка запобігатиме шахрайству та захистить права громадян. Вони слідували цим новим передовим практикам і вклали величезну кількість часу і грошей у проект, який в кінцевому підсумку обробляв заявки на соціальну допомогу.

Але у своєму пілотному проекті вони виявили, що розроблена ними система все ще не була справедливою і ефективною. Чому?

Lighthouse Reports, MIT Technology Review і голландська газета Trouw отримали доступ до системи, щоб спробувати з’ясувати це. У відповідь на запит публічних записів місто розкрило кілька версій алгоритму Smart Check і дані про те, як він оцінював реальних претендентів соціального забезпечення, пропонуючи унікальну інформацію про те, чи можуть алгоритмічні системи виконати свої амбітні обіцянки при найкращих можливих умовах.

Відповідь на це питання далеко не проста. Для де Конінга Smart Check уособлював технологічний прогрес в напрямку створення більш справедливої і прозорої системи соціального забезпечення. На думку де Цварта, це являло собою істотний ризик для прав одержувачів соціальних допомог, який не могли виправити ніякі технічні удосконалення.

Оскільки цей алгоритмічний експеримент розгортався протягом декількох років, він поставив під сумнів центральну передумову проекту: відповідальний ШІ може бути чимось більшим, ніж уявний експеримент або корпоративна точка продажу і може дійсно зробити алгоритмічні системи справедливими в реальному світі.

Шанс на виправлення проблем

Розуміння того, як Амстердам виявився залученим в масштабну діяльність щодо запобігання шахрайства на основі штучного інтелекту, вимагає повернутися на чотири десятиліття тому, до національного скандалу навколо розслідувань щодо соціального забезпечення, які зайшли занадто далеко.

У 1984 році Альбіна Грумбок, розлучена мати-одиначка трьох дітей, кілька років одержувала допомогу, коли дізналася, що одна з її сусідок, співробітниця місцевого відділення соціальної служби, таємно спостерігала за її життям. Сусідка задокументувала візити одного-чоловіка, який теоретично міг приносити сім’ї неврахований дохід. На підставі цих спостережень управління соціального забезпечення урізало допомогу матері-одиначці. Вона оскаржила це рішення в суді і виграла.

Незважаючи на особисте виправдання Альбіни Грумбок, голландська політика соціального забезпечення продовжує наділяти слідчих по шахрайству, яких іноді називають “рахувальниками зубних щіток”, повноваженнями перевертати життя людей. Це допомогло створити атмосферу підозрілості, яка призводить до проблем для обох сторін, говорить Марк ван Хоф, юрист, який десятиліттями допомагав голландським одержувачам соціальних допомог орієнтуватися в системі: “Уряд не довіряє своїм людям, а люди не довіряють уряду”.

Гаррі Бодаар, професійний державний службовець, більшу частину цього часу уважно спостерігав за політикою соціального забезпечення Нідерландів — спочатку в якості соціального працівника, потім в якості слідчого по шахрайству, а тепер в якості радника з питань політики соціального забезпечення в місті.

Останні 30 років показали йому, що система ледь працює і якщо ти перебуваєш на дні цієї системи, ти перший, хто провалюється.

Поліпшення роботи системи соціальної допомоги, додає він, було важливим мотивуючим фактором, коли місто почало розробляти Smart Check в 2019 році. “Ми хотіли провести чесну перевірку тільки тих людей, яких, на нашу думку, потрібно було перевірити”, — говорить Бодаар, на відміну від попередньої політики департаменту, яка до 2007 року полягала в проведенні візитів додому для кожного заявника.

Але він також знав, що Нідерланди стали чимось на кшталт епіцентру проблем з впровадженням штучного інтелекту для соціального забезпечення. Спроби уряду Нідерландів модернізувати виявлення шахрайства за допомогою штучного інтелекту в декількох сумно відомих випадках мали неприємні наслідки.

У 2019 році з’ясувалося, що національний уряд використовував алгоритм для створення профілів ризиків, який, як влада сподівалася, допоможе виявити шахрайство в системі допомоги по догляду за дитиною. В результаті скандалу майже 35 000 батьків, більшість з яких були мігрантами або дітьми мігрантів, були помилково звинувачені в шахрайстві з отриманням допомоги. Це ввергло сім’ї в борги, деяких ввергло в убогість і у кінцевому підсумку призвело весь уряд до відставки у 2021 році.

У Роттердамі розслідування, проведене Lighthouse Reports в 2023 році відносно системи виявлення шахрайства, показало, що вона була упередженою по відношенню до жінок, батьків, осіб, що не говорять голландською мовою, та іншим вразливих груп, що в кінцевому підсумку змусило місто призупинити використання системи.

Інші міста, такі як Амстердам і Лейден, використовували систему під назвою Система показників шахрайства, яка була вперше впроваджена більше 20 років тому і включала освіту, сусідство, батьківство і стать в якості основних факторів ризику для оцінки претендентів соціального забезпечення; ця програма також була припинена.

Нідерланди не самотні. У Сполучених Штатах було зареєстровано щонайменше 11 випадків, коли уряди штатів використовували алгоритми, які допомагають розподіляти суспільні блага, часто з тривожними результатами. Мічиган, наприклад, неправдиво звинуватив 40 000 людей в шахрайстві з безробіттям. А у Франції активісти кампанії подають в суд на управління національного добробуту через алгоритм, який, за їх твердженням, дискримінує заявників з низьким доходом і людей з обмеженими можливостями.

Ця низка скандалів, а також зростаюче усвідомлення того, як дискримінація може бути вбудована в алгоритмічні системи, сприяли зростанню уваги до відповідального ШІ.

“Це стало загальним терміном для позначення того, що нам треба думати не тільки про етику, але і про справедливість”, – говорить Цзяхао Чен, консультант з етики в області штучного інтелекту, який надавав аудиторські послуги як приватним, так і місцевим державним структурам. “Я думаю, ми спостерігаємо усвідомлення того, що нам потрібні такі речі, як прозорість і конфіденційність, безпека і так далі”.

Підхід, заснований на стримуванні шкоди, що завдається поширенням технологій, призвів до появи галузі, побудованої за знайомою формулою: офіційних документів і фреймворків аналітичних центрів та міжнародних організацій, а також прибуткової індустрії консалтингу, що складається з традиційних впливових гравців, таких як консалтингові компанії Big 5, а також безлічі стартапів і некомерційних організацій.

Наприклад, в 2019 році Організація економічного співробітництва та розвитку, орган глобальної економічної політики, опублікувала свої Принципи штучного інтелекту в якості керівництва по розробці “заслуговуючого довіри ШІ”. Ці принципи включають створення пояснюваних систем, консультації з зацікавленими сторонами та проведення аудитів.

Але від спадщини, залишеного десятиліттями неправомірних дій алгоритмів, виявилося важко позбутися, і немає єдиної думки про те, де провести межу між тим, що справедливо, а що ні.

У той час як Нідерланди працюють над впровадженням реформ, сформованих відповідальним ШІ на національному рівні, Algorithm Audit, голландська неурядова організація, що надає послуги аудиту етичного ШІ урядовим міністерствам, прийшла до висновку, що технологію слід використовувати для профілювання одержувачів соціальних допомог тільки при суворо визначених умовах і тільки в тому випадку, якщо системи уникають обліку захищених характеристик, таких як стать.

Між тим, Amnesty International, борці за цифрові права, такі як де Зварт, і деякі самі одержувачі соціальних допомог стверджують, що, коли справа доходить до прийняття рішень, що стосуються життя людей, державний сектор взагалі не повинен використовувати штучний інтелект.

Амстердам сподівався, що був знайдений правильний баланс. “Ми винесли уроки з того, що сталося”, – говорить Бодаар, політичний радник, про минулі скандали. І на цей раз місто хотіло створити систему, яка показала б жителям Амстердама, що ми робимо добре і чесно.

Пошук найкращого способу

Кожен раз, коли житель Амстердама подає заяву на отримання соціальної допомоги, соцпрацівник перевіряє заяву на наявність порушень. Якщо заявка виглядає підозрілою, її можна відправити у міський слідчий департамент, що може призвести до відхилення, вимогу виправити помилки в документах або рекомендації про те, щоб кандидат отримував менше грошей.

Розслідування також можуть проводитися пізніше, після того як допомогу призначать. Результат може змусити одержувачів повернути кошти і навіть кинути деяких людей в борги.

Офіційні особи володіють широкими повноваженнями щодо заявників та існуючих одержувачів соціальної допомоги. Вони можуть запитувати банківські записи, викликати людей на розмову і в деяких випадках наносити неоголошені візити до людини додому.

По мірі проведення розслідувань або виправлення помилок в оформленні документів настільки необхідні платежі можуть бути відкладені. І часто — згідно з даними, наданими Бодааром, більш ніж у половині розслідувань заяв — місто не знаходить доказів правопорушень.

В таких випадках це може означати, що місто несправедливо переслідував людей, говорить Бодаар.

Система Smart Check була розроблена для того, щоб уникнути подібних сценаріїв, в кінцевому підсумку замінивши початкового соцпрацівника, який вказує, які справи слід направляти в слідчий відділ. Алгоритм буде перевіряти заявки, щоб виявити ті, які з найбільшою ймовірністю пов’язані із серйозними помилками, на основі певних особистих характеристик, і перенаправляти ці справи для подальшого вивчення командою правоохоронних органів.

Якщо все піде добре, система покращить роботу соцпрацівників, відзначаючи меншу кількість звернень для розслідування, при цьому виявляючи велику частку випадків з помилками. В одному з документів міська влада прогнозували, що ця модель запобіжить стягнення боргів з 125 окремих амстердамців і заощадить 2,4 мільйона євро щорічно.

Smart Check був захоплюючою перспективою для міських чиновників, таких як де Конінг, які будуть керувати проектом. Він був налаштований оптимістично, оскільки, за його словами, місто дотримувався наукового підходу.

Це була свого роду смілива ідея, яка привернула оптимістичних технарів, таких як Лоєк Беркерс, спеціаліст по обробці даних, який працював над Smart Check. Беркерс згадує, як був вражений при першому знайомстві з системою: “це був свого роду інноваційний проект, в якому пробувалися щось нове”.

В Smart Check використовувався алгоритм, званий “машиною пояснюваного підвищення”, який дозволяє людям легше зрозуміти, як моделі штучного інтелекту дають свої прогнози. Більшість інших моделей машинного навчання часто розглядаються як “чорні ящики” без повного розуміння процесів.

Модель Smart Check буде враховувати 15 характеристик, включаючи те, чи заявники подавали раніше заявки на отримання пільг або отримували їх, суму їх активів і кількість адрес, які у них є в досьє, щоб присвоїти кожній людині оцінку ризику. Алгоритм цілеспрямовано уникає демографічні фактори, такі як стать, національність або вік, які, як вважалося, приводили до упередженості. В ньому також була зроблена спроба уникнути “непрямих чинників, таких як поштові індекси, якщо, наприклад, поштовий індекс статистично пов’язаний з певною етнічною групою.

Ця модель була навчена на наборі даних, що охоплює 3400 попередніх досліджень одержувачів соціальних допомог. Ідея полягала в тому, що алгоритм використовував би результати розслідувань, проведених міською службовцями, щоб з’ясувати, які фактори в початкових заявках були пов’язані з потенційним шахрайством.

Але використання минулих досліджень з самого початку створює потенційні проблеми, каже Сеннай Гебриб, науковий директор Лабораторії цивільного штучного інтелекту (CAIL) Амстердамського університету. Проблема використання історичних даних для побудови моделей, за його словами, полягає в тому, що “в кінцевому результаті ми отримаємо історичні спотворення”.

Наприклад, якщо соцпрацівники історично допускали більше упередженості до певної етнічної групи, модель може помилково навчитися передбачати, що ця етнічна група здійснює шахрайство з більш високою частотою.

Місто вирішило провести ретельний аудит своєї системи, щоб спробувати виявити подібні упередження щодо вразливих груп населення. Але те, як слід визначати упередженість і, отже, чесність алгоритму, є предметом запеклих дебатів.

За останнє десятиріччя вчені запропонували десятки конкуруючих математичних уявлень про справедливість, деякі з них несумісні між собою. Це означає, що система, розроблена так, щоб бути “справедливою” згідно з одним таким стандартом, неминуче буде несправедливою в інших методиках оцінки справедливості.

Офіційні особи Амстердама прийняли визначення справедливості, яке було зосереджено на рівному розподілі тягаря розслідувань між різними демографічними групами. Вони сподівалися, що такий підхід забезпечить, щоб претенденти на отримання соціального забезпечення з різних верств суспільства несли однаковий тягар неправильного розслідування з однаковими показниками.

Неоднозначний зворотний зв’язок

При створенні Smart Check Амстердам консультувався з різними державними органами з приводу цієї моделі, у тому числі з міським спеціалістом з внутрішнього захисту даних і Комісією по персональних даних Амстердама. Місто також консультувалося з приватними організаціями, включаючи консалтингову фірму Deloitte. Кожен з них дав своє схвалення проекту.

Але однієї ключової групи не було на борту: консультативної ради з 15 членів, що складається з одержувачів допомоги, адвокатів та інших неурядових зацікавлених сторін, які представляють інтереси людей, для яких система була розроблена.

Анке ван дер Вліет, якій зараз за 70, є одним з давніх членів ради. “Ми не довіряли цьому з самого початку”, – каже вона, витягаючи стопку паперів, які вона зберегла в Smart Check. “Всі були проти цього”.

На протязі десятиліть вона була непохитним захисником інтересів одержувачів соціальних допомог — групи, яка до кінця 2024 року налічувала близько 35 000 чоловік. В кінці 1970-х вона допомогла заснувати Women on Welfare – групу, що займається викриттям унікальних проблем, з якими стикаються жінки в системі соціального забезпечення.

Ще дві зустрічі не змогли їх переконати. Їх відгуки дійсно призвели до ключових змін, включаючи скорочення кількості змінних, які місто спочатку розглядало для розрахунку балів кандидата, та виключення з системи змінних, які могли внести упередженість, таких як вік.

Але через шість місяців Рада взагалі перестала брати участь у зусиллях по розвитку міста. “Рада дотримується думки, що подібний експеримент зачіпає основні права громадян і повинен бути припинений”, – написала група в березні 2022 року.

Оскільки тільки близько 3% заяв на отримання соціальних допомог є шахрайськими, говорилося в листі, використання алгоритму було “непропорційним”.

Для адвокатів, які працюють з бенефіціарами соціального забезпечення, і для деяких з самих бенефіціарів причиною неспокою був не скандал, а перспектива реального шкоди. Технологія може не тільки призвести до згубних помилок, але і ускладнювати їх виправлення, дозволяючи співробітникам служби соціального забезпечення “ховатися за цифровими стінами”, — говорить Хенк Крун, юрист, який допомагає одержувачам соціальних допомог в Амстердамській асоціації соціального забезпечення, профспілці, створеній в 1970-х роках.

Така система могла б “полегшити роботу [чиновникам]”, говорить він. “Але для простих громадян це дуже часто є проблемою”.

Час для тестування

Незважаючи на категоричні заперечення Ради, місто вирішило протестувати працюючу модель Smart Check.

Перші результати виявилися зовсім не такими, на які вони сподівалися. Коли команда просунутої аналітики запустила первісну модель в травні 2022 року, вони виявили, що алгоритм демонструє сильну упередженість по відношенню до мігрантів і чоловіків, що було незалежно перевірено.

Первісна модель з більшою ймовірністю помилково вказувала на заявників, які не є громадянами Нідерландів. І було майже в два рази більше шансів помилково вказати кандидата з громадянством не західної країни. У моделі також було на 14% більше шансів помилково назвати чоловіків шахраями.

У той час як модель Smart Check з більшою ймовірністю помилково відзначала громадян інших країн і чоловіків, соціальні працівники-люди з більшою ймовірністю помилково відзначали громадян Нідерландів і жінок.

Команда Smart Check знала, що якщо вони не зможуть виправити упередженість, проект буде скасовано. Тому вони звернулися до методу академічних досліджень, відомому як повторне зважування навчальних даних. На практиці це означало, що заявникам з не західним громадянством, які, як вважалося, допустили суттєві помилки в своїх заявах, надавалося менше значення в даних, в той час як заявникам із західним громадянством надавалося більше.

Зрештою, це, мабуть, вирішило проблему: як підтверджує аналіз Lighthouse, після того, як модель була повторно виважена, громадяни Нідерландів та інших країн з рівною імовірністю були помилково позначені.

Модель також краще за соцпрацівників визначала програми, які заслуговують додаткового вивчення, при цьому внутрішнє тестування показало підвищення точності на 20%.

Підбадьорений цими результатами, навесні 2023 року місто було майже готове запустити систему. Чиновники відправили Smart Check до Реєстру алгоритмів, урядову ініціативу щодо забезпечення прозорості, покликану інформувати громадян про алгоритми машинного навчання, які або знаходяться в розробці, або вже використовуються урядом.

Для де Конинга обширні оцінки та консультації міста були обнадійливими, особливо тому, що вони також виявили недоліки в аналоговій системі. Але де Зварта ті ж самі процеси являли собою глибоке нерозуміння: справедливість можна спроектувати.

У листі міській владі де Зварт розкритикував передумови проекту і, більш конкретно, змалював ненавмисні наслідки, які можуть виникнути в результаті повторного зважування даних. Це могло б зменшити упереджене ставлення до людей з міграційним минулим в цілому, але не гарантувало б справедливості при перетині ідентичностей. Наприклад, модель може дискримінувати жінок з міграційним минулим. І такі упередження було б важко виявити.

Зрештою, сказав він, – це питання про те, чи законно використовувати дані про минулу поведінку, щоб судити про майбутню поведінку ваших громадян, яку в принципі ви не можете передбачити.

Офіційні особи, як і раніше наполягали – і призначили березень 2023 року датою початку пілотного проекту. Членів міської ради Амстердама практично не попередили. Фактично, вони були поінформовані тільки у тому ж місяці — до розчарування Елізабет Эймкер, члена ради від Партії зелених.

Місто сподівався, що пілотний запуск зможе довести неправоту таких скептиків, як вона.

Підвищуємо ставки

Офіційний запуск Smart Check почався з обмеженого набору реальних заявників на отримання соціального забезпечення, чиї документи обробить алгоритм і надасть оцінку ризику, чи слід позначати заявку для розслідування. Ці заявки також перевірять люди.

Ефективність Smart Check відстежувалася за двома ключовими критеріями. По-перше, чи може він неупереджено розглядати кандидатів? І, по-друге, дійсно Smart Check розумний?

Іншими словами, чи може складна математика, з якої складається алгоритм, насправді виявляти шахрайство з соціальною допомогою краще і справедливіше, ніж звичайні соцпрацівники?

Не знадобилося багато часу, щоб стало ясно, що модель не виправдала очікувань по обох напрямках.

Упередженість знову проявилася, але на цей раз, замість громадян інших країн і чоловіків, модель тепер з більшою ймовірністю вважала шахраями заявників з голландським громадянством і жінок.

Власний аналіз Lighthouse також виявив інші форми упередженості, включаючи велику ймовірність того, що заявники на отримання соціального забезпечення з дітьми будуть помилково зазначено для розслідування.

За пілотний період з допомогою моделі було опрацьовано близько 1600 заявок на соціальне забезпечення. Але результати означали, що було незручно продовжувати тестування, особливо коли це могло призвести до реальних наслідків.

Люди, які працювали над проектом, не вірили, що це обов’язково є причиною відмови від Smart Check. Вони хотіли отримати більше часу — скажімо, “період в 12 місяців”, за словами де Конинга, щоб продовжити тестування і доопрацювання моделі.

В кінці листопада 2023 року Рутгер Грут Вассинк — міський чиновник, відповідальний за соціальні питання, вирішив зупинити пілотний тест.

Це оголошення поклало кінець масштабному багаторічного експерименту.

Членам міської ради ніколи не повідомляли точно, скільки коштував проєкт, але MIT Technology Review , Lighthouse і Trouw підрахували витрати у близько 500 000 євро плюс 35 000 євро на контракт з Deloitte. Попередивши, що загальна сума, вкладена в проект, була лише приблизною, враховуючи, що Smart Check був розроблений власними силами різними існуючими командами і співробітниками.

Чи можна коли-небудь правильно використовувати такий алгоритм?

Це питання, над яким Эймкер теж замислюється. На засіданнях міської ради вона приводила Smart Check як приклад того, чого не слід робити. Але тепер, коли пілот припинився, вона турбується, що її колеги-міські чиновники можуть бути занадто нетерплячі, щоб рухатися далі.

Відмовившись від моделі, місто повернувся до старого процесу, який, як показав аналіз, був упереджений по відношенню до жінок і громадян Нідерландів.

Чен, консультант з етики в області штучного інтелекту, питає:”Чому ми дотримуємося найвищих стандартів у системах штучного інтелекту, ніж у системах з людським інтелектом?”. Коли справа доходить до соцпрацівників, він говорить, не було ніяких спроб систематично виправляти їхню упередженість.

Можливо, прийшов час більш фундаментально переглянути те, як слід визначати справедливість — і ким. Крім математичних визначень, деякі дослідники стверджують, що люди, найбільш дискриміновані цими програмами, повинні мати більше право голосу. “Такі системи працюють тільки тоді, коли люди купують їх”, – пояснює Елісса Редмайлс, доцент кафедри комп’ютерних наук Джорджтаунського університету, яка вивчала алгоритмічну справедливість.

Незалежно від того, як виглядає процес, це питання, з якими кожному уряду доведеться зіткнутися в майбутньому, все більше визначається штучним інтелектом.

І, як стверджує де Зварт, якщо не будуть вирішені більш широкі питання, навіть чиновники з добрими намірами будуть приречені повторювати одні і ті ж уроки знову і знову.

За матеріалами: MIT Technology Review