IBM запустила модель штучного інтелекту Granite 4.0 Nano AI, яка вирішує дві ключові проблеми ШІ. Вона запускається в один клік, не вимагаючи будь-яких знань, та працює повністю офлайн. Це дозволяє отримати постійно доступний безкоштовний приватний ШІ навіть далеким від технологій людям.

Моделі Granite 4.0 Nano являють собою інструменти штучного інтелекту, які запускаються локально безпосередньо у веб браузері. Чотири нові моделі, параметризація яких варіюється від 350 мільйонів до 1,5 мільярда параметрів, мають настільки компактний розмір, що можуть працюють прямо в браузері без потреби у сервері, підписці або підключенні до інтернету. Оскільки такі чат-боти працюють локально та в режимі офлайн, кожна розмова залишається приватною, а всі дані зберігаються виключно на пристрої користувача.

Популярні чат-боти на основі штучного інтелекту, такі як ChatGPT, Gemini, Claude, Grok, Deepseek, а також інші штучні інтелекти, розміщуються у величезних дата-центрах та вимагають наявності стабільного підключення до інтернету. Згадайте нещодавній збій сервісу Cloudflare – він унеможливив доступ до ChatGPT. Окрім цього, ці штучні інтелекти роблять розмови користувачів доступними третім особам.

Натомість використання стиснених моделей штучного інтелекту від IBM безпосередньо у веб браузері є простим і доступним. Для роботи з моделями Granite 4.0 Nano достатньо мати ноутбук або настільний комп’ютер із щонайменше 8 ГБ оперативної пам’яті та браузер із підтримкою технології WebGPU (це свіжі версії браузерів, наприклад Chrome або Edge).

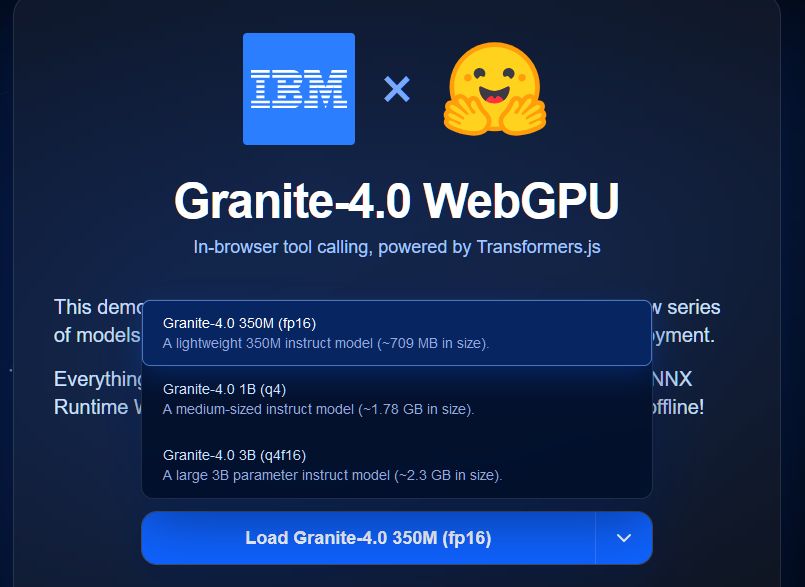

IBM представила моделі Granite 4.0 Nano у різних розмірах і архітектурних варіантах, зокрема Granite-4.0-H-3B, що має 3 мільярда параметрів, Granite-4.0-H-1B, що має 1,5 мільярда параметрів, Granite-4.0-H-350M із 350 мільйонами параметрів. Кількість параметрів безпосередньо впливає на «розумність» ШІ. Усі ці моделі використовують гібридну архітектуру Mamba і Transformer, яка, за твердженням IBM, зменшує вимоги до пам’яті без втрати продуктивності.

Для складніших завдань міркування і точніших відповідей можна використовувати більшу модель із 1,5 або 3 мільярда параметрів, проте в такому випадку знадобиться окрема відеокарта з додатковою відеопам’яттю обсягом не менше 6-8 ГБ.

Для використання Granite 4.0 Nano потрібно перейти на створену ентузіастом сторінку https://huggingface.co/spaces/ibm-granite/Granite-4.0-Nano-WebGPU та завантажити обрану модель. Найменша модель вимагає приблизно 800 МБ, найбільша – 2,3 ГБ. Після завантаження модель функціонує повністю автономно.

Хоча моделі Nano від IBM мають невеликий розмір, компанія стверджує, що їхня продуктивність перевищує очікування для такого класу рішень.

Однак, хоча модель Granite Nano від IBM є конкурентною серед рішень зі схожим числом параметрів і здатна впоратися з базовими та прямолінійними завданнями, проте вона не може повністю замінити або на рівних конкурувати з великими мовними моделями, такими як GPT-4 або Claude, які працюють в дата-центрах. Відповіді менших моделей, як правило, є коротшими та менш глибокими з погляду міркувань, ніж у більших систем. Крім того, компактні моделі гірше справляються з великими вхідними даними і не мають можливості виконувати пошук в інтернеті або отримувати доступ до інформації поза межами даних, на яких їх було навчено.

Стиснені моделі штучного інтелекту від IBM можуть бути корисними у випадках, коли потрібен налаштований інструмент для конкретних завдань. Вони можуть застосовуватися для написання електронних листів, узагальнення документів та виконання інших типових задач, але для складнішого міркування доцільніше розглядати використання повноцінних платних великих мовних моделей.

Складнощі використання локального ШІ

Локальний штучний інтелект існує вже давно, але його реальна доступність для звичайного користувача завжди була невеликою. Формально запустити модель на власному комп’ютері можна, але на практиці це майже завжди перетворюється на технічний квест із нескінченними програмними залежностями, бібліотеками, драйверами, конфліктами версій та командним рядком. Потрібні знання Python, принципів роботи нейронних мереж, розуміння того, що таке CUDA, VRAM, токени та квантизація. Окремою проблемою є підтримка та стабільність. Оновлення операційної системи, браузера або драйверів відеокарти здатне миттєво зламати працездатну конфігурацію. Користувач змушений витрачати години на пошук рішень на форумах, повторне встановлення бібліотек або «танці» з параметрами запуску.

Навіть після успішного встановлення моделі користувач стикається з апаратними обмеженнями. Більшість сучасних мовних моделей потребують щонайменше 12-16 ГБ оперативної пам’яті та потужної відеокарти, яка коштує близько тисячі доларів. Без топової дискретної відеокарти локальний ШІ надає відповіді неприйнятно повільно – обробка навіть простого запиту може тривати хвилинами. У випадку ноутбуків або офісних комп’ютерів запуск локального ШІ взагалі виглядає фантастичною ідеєю. Саме через це локальний ШІ все ще залишається розвагою для ентузіастів з надпотужними комп’ютерами, а не реальним рішенням для широкої аудиторії.