IBM запустила модель искусственного интеллекта Granite 4.0 Nano AI, которая решает две ключевые проблемы ИИ. Она запускается в один клик, не требуя каких-либо знаний, и работает полностью офлайн. Это позволяет получить постоянно доступный бесплатный частный ИИ даже далеким от технологий людям.

Модели Granite 4.0 Nano представляют собой инструменты искусственного интеллекта, которые запускаются локально непосредственно в веб браузере. Четыре новые модели, параметризация которых варьируется от 350 миллионов до 1,5 миллиарда параметров, имеют настолько компактный размер, что могут работают прямо в браузере без необходимости в сервере, подписке или подключении к интернету. Поскольку такие чат-боты работают локально и офлайн, каждый разговор остается конфиденциальным, а все данные хранятся исключительно на устройстве пользователя.

Популярные чат-боты на основе искусственного интеллекта, такие как ChatGPT, Gemini, Claude, Grok, Deepseek, а также другие искусственные интеллекты, размещаются в огромных дата-центрах и требуют наличия стабильного подключения к интернету. Вспомните недавний сбой сервиса Cloudflare-он сделал невозможным доступ к ChatGPT. Кроме того, этот искусственный интеллект делает разговоры пользователей доступными для третьих лиц.

Вместо этого использование сжатых моделей искусственного интеллекта IBM прямо в веб-браузере просто и доступно. Для работы с моделями Granite 4.0 Nano достаточно иметь ноутбук или настольный компьютер с не менее 8 ГБ оперативной памяти и браузер с поддержкой технологии WebGPU (это свежие версии браузеров, например Chrome или Edge).

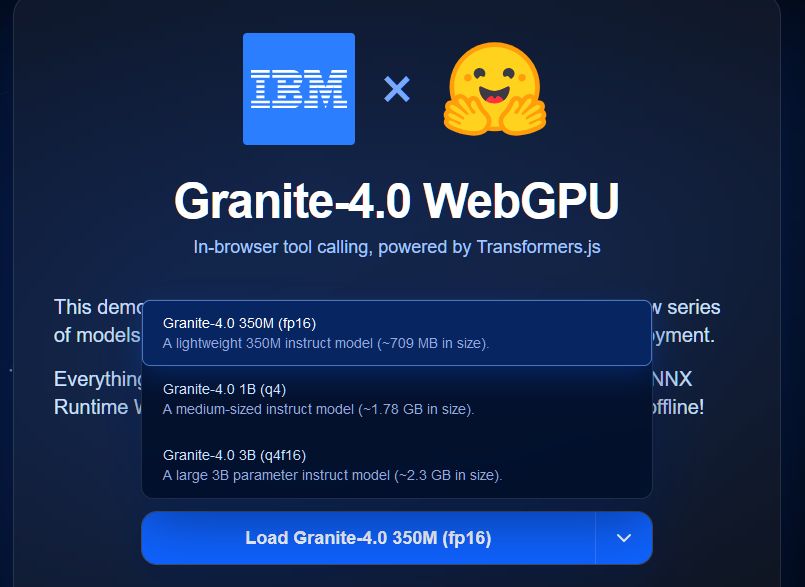

IBM представила модели Granite 4.0 Nano в различных размерах и архитектурных вариантах, в том числе Granite-4.0-H-3B, имеющий 3 миллиарда параметров, Granite-4.0-H-1B, имеющий 1,5 миллиарда параметров, Granite-4.0-H-350m с 350 миллионами параметров. Количество параметров напрямую влияет на» разумность » ИИ. Все эти модели используют гибридную архитектуру Mamba и Transformer, которая, по утверждению IBM, снижает требования к памяти без потери производительности.

Для более сложных задач рассуждения и более точных ответов можно использовать более крупную модель с 1,5 или 3 миллиарда параметров, однако в таком случае понадобится отдельная видеокарта с дополнительной видеопамятью объемом не менее 6-8 ГБ.

Для использования Granite 4.0 Nano нужно перейти на созданную энтузиастом страницу https://huggingface.co/spaces/ibm-granite/Granite-4.0-Nano-WebGPU и скачать выбранную модель. Самая маленькая модель требует около 800 МБ, самая большая – 2,3 ГБ. После загрузки модель функционирует полностью автономно.

Хотя модели IBM nano имеют небольшой размер, компания утверждает, что их производительность превышает ожидания для такого класса решений.

Однако, хотя модель Granite Nano от IBM является конкурентной среди решений с похожим числом параметров и способна справиться с базовыми и прямолинейными задачами, однако она не может полностью заменить или на равных конкурировать с крупными языковыми моделями, такими как GPT-4 или Claude, которые работают в дата-центрах. Ответы меньших моделей, как правило, короче и менее глубоки с точки зрения рассуждений, чем с более крупными системами. Кроме того, компактные модели хуже справляются с большими входными данными и не имеют возможности выполнять поиск в интернете или получать доступ к информации за пределами данных, на которых они были обучены.

Сжатые модели искусственного интеллекта IBM могут быть полезны в тех случаях, когда требуется настроенный инструмент для конкретных задач. Они могут применяться для написания электронных писем, обобщения документов и выполнения других типичных задач, но для более сложного рассуждения целесообразнее рассматривать использование полноценных платных больших языковых моделей.

Сложности использования локального ИИ

Локальный искусственный интеллект существует уже давно, но его реальная доступность для обычного пользователя всегда была небольшой. Формально запустить модель на собственном компьютере можно, но на практике это почти всегда превращается в технический квест с бесконечными программными зависимостями, библиотеками, драйверами, конфликтами версий и командной строкой. Требуются знания Python, принципы работы нейронных сетей, понимание того, что такое CUDA, VRAM, токены и квантизация. Отдельная проблема-поддержка и стабильность. Обновление операционной системы, браузера или драйверов видеокарты способно мгновенно взломать работоспособную конфигурацию. Пользователь вынужден часами искать решения на форумах, переустанавливать библиотеки или «танцевать» с параметрами запуска.

Даже после успешной установки модели пользователь сталкивается с аппаратными ограничениями. Большинству современных языковых моделей требуется не менее 12-16 ГБ оперативной памяти и мощная видеокарта, которая стоит около тысячи долларов. Без топовой дискретной видеокарты локальный ИИ предоставляет ответы неприемлемо медленно-обработка даже простого запроса может длиться минутами. В случае ноутбуков или офисных компьютеров запуск локального ИИ в целом кажется фантастической идеей. Именно из-за этого локальный ИИ по-прежнему является развлечением для энтузиастов со сверхмощными компьютерами, а не реальным решением для широкой аудитории.