Пока пользователи по-прежнему под впечатлением нейросети GPT-3/ChatGPT, умеющей только писать текст, ее разработчик компания OpenAI представила преемнику GPT-4. Эта новая модель видит, слышит и читает. Первым приложением на ее основе стала программа, распознающая окружающую обстановку для слепых людей.

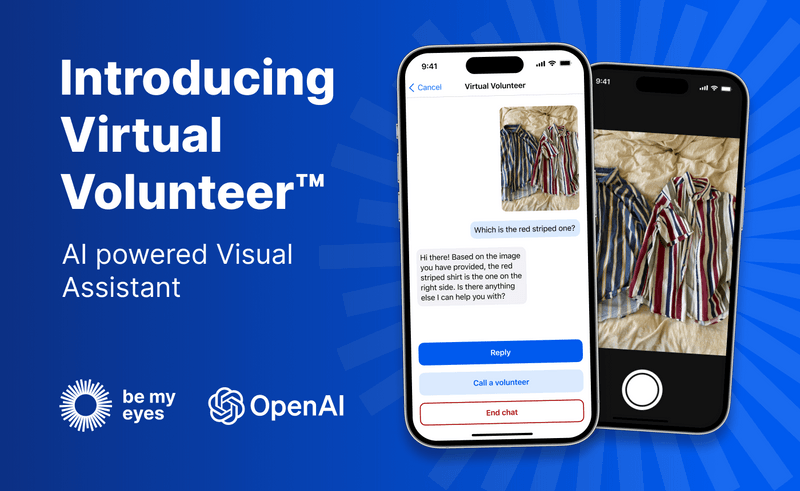

Уже существует приложение Be My Eyes, которое позволяет слепым и слабовидящим просить зрячих людей описать, что видит их телефон. Проблема в том, что волонтеров мало и слепым приходилось долго ждать появления свободного волонтера.

Благодаря искусственному интеллекту GPT-4 сервис получает виртуального волонтера, который в любое время предлагает помощь слепому человеку.

Пользователи могут отправлять виртуальному волонтеру изображения, и он ответит на любой вопрос по этому изображению и предоставит мгновенную визуальную помощь для многих задач.

Например, если пользователь пошлет фотографию внутренней части своего холодильника, виртуальный волонтер сможет не только правильно определить, что в ней находится, но и экстраполировать и проанализировать, что можно приготовить с этими ингредиентами. Инструмент также может предложить несколько рецептов этих ингредиентов и отправить пошаговое руководство по их приготовлению.

Видео, сопровождающее пресс-релиз, более яркое. В нем пользователь Be My Eyes Люси показывает приложение, которое помогает ей с кучей вещей в прямом эфире. Приложение смогло описывать вид платья, идентифицировать растение, читать карту, переводить этикетку, направлять Люси на пустую беговую дорожку в тренажерном зале и сказал ей, какие кнопки нажимать на торговом автомате.

Эта функция находится в закрытой бета-версии среди «небольшой подгруппы» пользователей Be My Eyes, которая будет расширена в течение следующих недель.