Поки користувачі все ще під враженням нейромережі GPT-3/ChatGPT, яка вміє лише писати текст, її розробник компанія OpenAI представила наступника GPT-4. Ця нова модель бачить, чує та читає. Першим додатком на її основі стала програма, що розпізнає навколишнє оточення для сліпих людей.

Уже існує додаток Be My Eyes, яки дозволяє незрячим і людям зі слабким зором просити зрячих людей описати, що бачить їхній телефон. Проблема в тому, що волонтерів мало і сліпим доводилося довго чекати появи вільного волонтера.

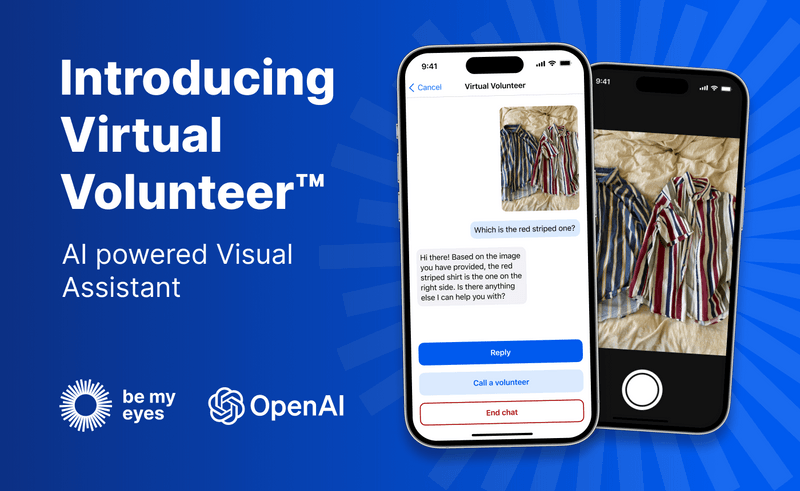

Завдяки штучному інтелекту GPT-4 сервіс отримує «віртуального волонтера», який у будь-який час пропонує допомогу сліпій людині.

Користувачі можуть надсилати віртуальному волонтеру зображення, і він відповість на будь-яке запитання щодо цього зображення та надасть миттєву візуальну допомогу для багатьох завдань.

Наприклад, якщо користувач надішле фотографію внутрішньої частини свого холодильника, віртуальний волонтер зможе не тільки правильно визначити, що в ній знаходиться, але й екстраполювати та проаналізувати, що можна приготувати з цими інгредієнтами. Інструмент також може запропонувати кілька рецептів цих інгредієнтів і надіслати покроковий посібник щодо їх приготування.

Відео, яке супроводжує прес-реліз, є більш яскравим. У ньому користувачка Be My Eyes Люсі показує додаток, який допомагає їй з купою речей у прямому ефірі. Додаток зміг описувати вигляд сукні, ідентифікувати рослину, читати карту, перекладати етикетку, направляти Люсі на порожню бігову доріжку в тренажерному залі та сказав їй, які кнопки натискати на торговому автоматі.

Наразі ця функція знаходиться в закритій бета-версії серед «невеликої підгрупи» користувачів Be My Eyes, яка буде розширена протягом наступних тижнів.