Можливо, людство втратило останній шанс регулювати автономних роботів-солдат. У ООН не змогли домовитися про заборону роботів-вбивць. Експерти кажуть, що тепер варто готуватися до гонки автономних озброєнь.

Автономні системи озброєння, широко відомі як роботи-вбивці, можливо, вперше вбили людей в минулому році за власною ініціативою без команди людини-оператора. Про це стало відомо з недавньої доповіді Ради Безпеки Організації Об’єднаних Націй про громадянську війну в Лівії.

Та подія могла стати відправною точку наступної великої гонки озброєнь.

Конвенція Організації Об’єднаних Націй про конкретні види звичайної зброї обговорювала питання про заборону Автономної зброї на своїй нараді, що проводиться раз на п’ять років в Женеві і відбувалася 13-17 грудня 2021 року.

Нарада не досягла консенсусу щодо заборони. Прийнята в 1983 році Конвенція регулярно оновлюється, щоб обмежити деякі з найжорстокіших видів звичайної зброї в світі, включаючи наземні міни, міни-пастки.

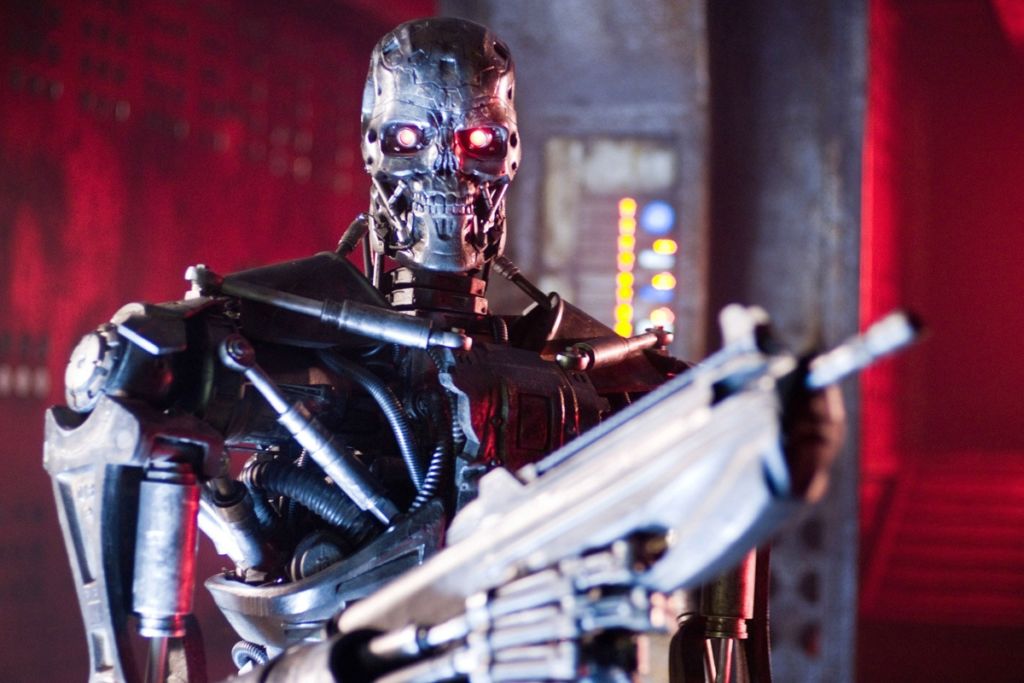

Автономні системи озброєння – це роботи зі смертоносною зброєю, які можуть діяти незалежно, вибираючи і атакуючи цілі без участі людини-командира. Військові по всьому світу вкладають значні кошти в дослідження і розробки автономного зброї. Тільки США заклали в бюджет 18 мільярдів доларів США на автономну зброю в період з 2016 по 2020 рік.

Тим часом, правозахисні та гуманітарні організації прагнуть встановити правила і заборони на розробку такої зброї. Експерти попереджають, що без таких обмежень руйнівні технології автономної зброї небезпечно дестабілізують нинішні ядерні стратегії. Адже вони можуть радикально змінити уявлення про стратегічне домінування, збільшуючи ризик попереджувальних ударів, а також тому, що вони можуть поєднуватися з хімічною, біологічною, радіологічною, ядерною зброєю.

Враховуючи темпи досліджень і розробок в області автономного зброї, засідання ООН, можливо, було останнім шансом зупинити гонку озброєнь, каже професор Джеймс Доус.

Смертельні помилки і чорні ящики

Професор бачить чотири основні небезпеки, пов’язані з автономною зброєю. Перша – це проблема невірної ідентифікації. Чи зможе Автономна зброя розрізняти ворожих солдатів і 12-річних дітей, що грають з іграшковими пістолетами? Розрізняти між цивільними особами, що тікають і повстанцями, які здійснюють тактичний відступ?

Проблема тут не в тому, що машини будуть робити такі помилки, а люди – ні. Масштаб і швидкість систем роботів-вбивць, керованих одним алгоритмом наведення, розгорнутим на всьому континенті, можуть привести до помилкової ідентифікації.

Експерт з Автономної зброї Пол Шарре використовує метафору пістолета, що втік, щоб пояснити різницю. Втікаючий пістолет – це несправний кулемет, який продовжує стріляти після натискання на спусковий гачок. Пістолет продовжує стріляти до тих пір, поки не закінчаться боєприпаси, тому що, так би мовити, пістолет не знає, що робить помилку.

Втікачі-пістолети надзвичайно небезпечні, але, на щастя, у них є люди-оператори, які можуть розірвати зв’язок з боєприпасами або спробувати направити зброю в безпечному напрямку.

Автономна зброя, за визначенням, не має такого захисту.

Важливо відзначити, що озброєний штучний інтелект навіть не обов’язково повинен бути несправний, щоб створити ефект швидкої зброї.

Як показали численні дослідження алгоритмічних помилок в різних галузях, найкращі алгоритми, що працюють так, як задумано, можуть генерувати внутрішньо правильні результати, які, тим не менш, швидко поширюють жахливі помилки серед населення.

Наприклад, нейронна мережа, призначена для використання в лікарнях Пітсбурга, визначила астму як засіб зниження ризику пневмонії. Програмне забезпечення для розпізнавання зображень, що використовується Google, визначило чорношкірих людей як горил. Інструмент машинного навчання, який використовує Amazon для оцінки кандидатів на роботу, систематично присвоював жінкам негативні оцінки.

Проблема не тільки в тому, що, коли системи штучного інтелекту помиляються, вони помиляються масово. Справа в тому, що коли вони помиляються, їх творці часто не знають, чому вони це зробили, і, отже, як їх виправити.

«Чорний ящик» штучного інтелекту робить практично неможливим уявити морально відповідальну розробку автономних систем озброєння.

Проблеми поширення

Наступні дві небезпеки – це проблеми поширення низькоякісних і високотехнологічних продуктів.

Військові, які розробляють автономну зброю, в даний час виходять з припущення, що вони зможуть стримувати і контролювати застосування автономного зброї.

Але якщо історія збройових технологій чогось і навчила світ, так це ось чому: поширенню зброї.

Тиск ринку може призвести до створення і широкого продажу того, що можна розглядати як автономний збройовий еквівалент автомата Калашникова: роботів-вбивць, які дешеві, ефективні і їх практично неможливо стримати, оскільки вони поширюються по всьому світу.

Автономна зброя може потрапити в руки людей, непідконтрольних уряду, в тому числі міжнародних і внутрішніх терористів.

Однак поширення автономної зброї високого класу настільки ж погано. Країни могли б конкурувати в розробці все більш руйнівних версій автономної зброї.

Високоякісна автономна зброя, ймовірно, призведе до частіших воєн, оскільки вона зменшить дві основні сили, які історично запобігали та скорочували війни: турбота про цивільних осіб за кордоном та турбота про власних солдатів.

Зброя, ймовірно, буде оснащена дорогими етичними регуляторами, призначеними для мінімізації супутнього збитку, використовуючи те, що Спеціальний доповідач ООН Агнес Калламар назвала “міфом про хірургічний удар”, щоб придушити моральні протести.

Автономна зброя також зменшить як потребу, так і ризик для власних солдатів, кардинально змінивши аналіз витрат і вигод, який виконують країни при розв’язуванні і веденні воєн.

Асиметричні війни, тобто війни, що ведуться на території країн, в яких відсутні конкуруючі технології, ймовірно, стануть більш поширеними.

Підрив законів війни

Нарешті, автономна зброя підірве останню надію людства в боротьбі з військовими злочинами і звірствами: міжнародні закони війни. Ці закони, кодифіковані в договорах, прийнятих ще в Женевській конвенції 1864 року, є міжнародною тонкою блакитною лінією, що відокремлює війну з честю від різанини.

Вони засновані на ідеї, що люди можуть бути притягнуті до відповідальності за свої дії навіть у воєнний час, що право вбивати інших солдатів під час бою не дає права вбивати цивільних осіб.

Яскравим прикладом того, кого притягнули до відповідальності, є Слободан Мілошевич, колишній президент Союзної Республіки Югославії, якому Міжнародний кримінальний трибунал ООН по колишній Югославії пред’явив звинувачення в злочинах проти людяності і військових злочинах.

Але як можна притягнути до відповідальності автономну зброю? Хто винен у тому, що робот здійснює військові злочини? Хто постане перед судом? Зброя? Солдат? Солдатські командири? Корпорація, яка зробила цю зброю?

Неурядові організації та експерти в галузі міжнародного права побоюються, що автономна зброя призведе до серйозної прогалини в підзвітності.

Юридична і моральна проблема не полегшується перекладанням провини вгору по ланцюжку командування або назад на місце виробництва. У світі, де немає правил, що наказують осмислений контроль людини над автономною зброєю, будуть відбуватися військові злочини без притягнення військових злочинців до відповідальності. Структура законів війни буде значно ослаблена.

Нова глобальна гонка озброєнь

Уявіть собі світ, в якому військові, повстанські угруповання, міжнародні та внутрішні терористи можуть застосовувати теоретично необмежену смертоносну силу при теоретично нульовому ризику і без будь-якої юридичної відповідальності.

Це світ, де неминучі алгоритмічні помилки, від яких страждають навіть такі технологічні гіганти, як Amazon і Google, тепер можуть привести до знищення цілих міст.

За матеріалами: The Conversation