Возможно, человечество потеряло последний шанс регулировать автономных роботов-солдат. В ООН не смогли договориться о запрете роботов-убийц. Эксперты говорят, что теперь стоит готовиться к гонке автономных вооружений

Автономные системы вооружения, широко известные как роботы-убийцы, возможно, впервые убили людей в прошлом году по собственной инициативе без команды человека-оператора. Об этом стало известно из недавнего доклада Совета Безопасности Организации Объединенных Наций о гражданской войне в Ливии.

То событие могло стать отправной точкой следующей большой гонки вооружений.

Конвенция Организации Объединенных Наций о конкретных видах обычного оружия обсуждала вопрос о запрете Автономной оружия на своем совещании, которое проводится раз в пять лет в Женеве и проходила 13-17 декабря 2021 года.

Совещание не достигло консенсуса по запрету. Принятая в 1983 году Конвенция регулярно обновляется, чтобы ограничить некоторые из самых жестоких видов обычного оружия в мире, включая наземные мины, мины-ловушки.

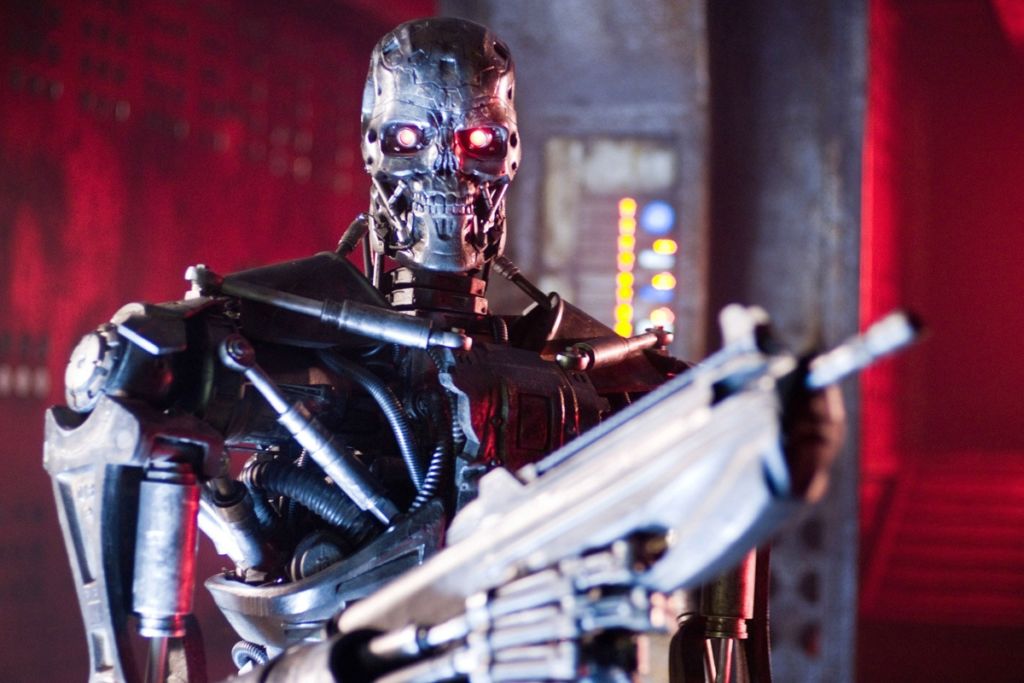

Автономные системы вооружения-это роботы со смертоносным оружием, которые могут действовать независимо, выбирая и атакуя цели без участия человека-командира. Военные по всему миру вкладывают значительные средства в исследования и разработки автономного оружия. Только США заложили в бюджет 18 миллиардов долларов США на автономное оружие в период с 2016 по 2020 год.

Между тем, правозащитные и гуманитарные организации стремятся установить правила и запреты на разработку такого оружия. Эксперты предупреждают, что без таких ограничений разрушительные технологии автономной оружия опасно дестабилизируют нынешние ядерные стратегии. Ведь они могут радикально изменить представления о стратегическом доминирование, увеличивая риск упреждающих ударов, а также потому, что они могут сочетаться с химической, биологической, радиологической, ядерным оружием.

Учитывая темпы исследований и разработок в области автономного оружия, заседание ООН, возможно, было последним шансом остановить гонку вооружений, говорит профессор Джеймс Доус.

Смертельные ошибки и черные ящики

Профессор видит четыре основные опасности, связанные с автономным оружием. Первая-это проблема неверной идентификации. Сможет ли автономное оружие различать вражеских солдат и 12-летних детей, играющих с игрушечными пистолетами? Различать между бегущими гражданскими лицами и повстанцами, осуществляющими тактическое отступление?

Проблема здесь не в том, что машины будут совершать такие ошибки, а люди — нет. Масштаб и скорость систем роботов-убийц, управляемых одним алгоритмом наведения, развернутым на всем континенте, могут привести к ошибочной идентификации.

Эксперт по автономному оружию Пол Шарре использует метафору сбежавшего пистолета, чтобы объяснить разницу. Ускользающий пистолет — это неисправный пулемет, который продолжает стрелять после нажатия на спусковой крючок. Пистолет продолжает стрелять до тех пор, пока не закончатся боеприпасы, потому что, так сказать, пистолет не знает, что делает ошибку.

Беглые пистолеты чрезвычайно опасны, но, к счастью, у них есть люди-операторы, которые могут разорвать связь с боеприпасами или попытаться направить оружие в безопасном направлении.

Автономное оружие, по определению, не имеет такой защиты.

Важно отметить, что вооруженный искусственный интеллект даже не обязательно должен быть неисправен, чтобы создать эффект быстрого оружия.

Как показали многочисленные исследования алгоритмических ошибок в различных областях, лучшие алгоритмы, работающие так, как задумано, могут генерировать внутренне правильные результаты, которые, тем не менее, быстро распространяют ужасные ошибки среди населения.

Например, нейронная сеть, предназначенная для использования в больницах Питтсбурга, определила астму как средство снижения риска пневмонии. Программное обеспечение для распознавания изображений, используемая Google, определило чернокожих людей как горилл. Инструмент машинного обучения, который использует Amazon для оценки кандидатов на работу, систематически присваивал женщинам отрицательные оценки.

Проблема не только в том, что, когда системы искусственного интеллекта ошибаются, они ошибаются массово. Дело в том, что когда они ошибаются, их создатели часто не знают, почему они это сделали, и, следовательно, как их исправить.

«Черный ящик» искусственного интеллекта делает практически невозможным представить морально ответственную разработку автономных систем вооружения.

Проблемы распространения

Следующие две опасности-это проблемы распространения низкокачественных и высокотехнологичных продуктов.

Военные, разрабатывающие автономное оружие, в настоящее время исходят из предположения, что они смогут сдерживать и контролировать применение автономного оружия.

Но если история оружейных технологий чему-то и научила мир, так это вот чему: распространению оружия.

Давление рынка может привести к созданию и широкой продаже того, что можно рассматривать как автономный оружейный эквивалент автомата Калашникова: роботов-убийц, которые дешевы, эффективны и их практически невозможно сдержать, поскольку они распространяются по всему миру.

Автономное оружие может попасть в руки людей, неподконтрольных правительству, в том числе международных и внутренних террористов.

Однако распространение автономного оружия высокого класса столь же плохо. Страны могли бы конкурировать в разработке все более разрушительных версий автономной оружия.

Высококачественное автономное оружие, вероятно, приведет к более частым войнам, поскольку оно уменьшит две основные силы, которые исторически предотвращали и сокращали войны: забота о гражданских лицах за рубежом и забота о собственных солдатах.

Оружие, вероятно, будет оснащена дорогими этическими регуляторами, предназначенными для минимизации сопутствующего ущерба, используя то, что Специальный докладчик ООН Агнес Калламар назвала «мифом о хирургический удар», чтобы подавить моральные протесты.

Автономное оружие также уменьшит как потребность, так и риск для собственных солдат, кардинально изменив анализ затрат и выгод, который выполняют страны при развязывании и ведении войн.

Асимметричные войны, то есть войны, ведущиеся на территории стран, в которых отсутствуют конкурирующие технологии, вероятно, станут более распространенными.

Подрыв законов войны

Наконец, автономное оружие подорвет последнюю надежду человечества в борьбе с военными преступлениями и зверствами: международные законы войны. Эти законы, кодифицированные в договорах, принятых еще в Женевской конвенции 1864 года, являются международной тонкой голубой линией, отделяющей войну с честью от резни.

Они основаны на идее, что люди могут быть привлечены к ответственности за свои действия даже в военное время, право убивать других солдат во время боя не дает права убивать гражданских лиц.

Ярким примером того, кого привлекли к ответственности, является Слободан Милошевич, бывший президент Союзной Республики Югославии, которому Международный уголовный трибунал ООН по бывшей Югославии предъявил обвинения в преступлениях против человечности и военных преступлениях.

Но как можно привлечь к ответственности автономное оружие? Кто виноват в том, что робот совершает военные преступления? Кто предстанет перед судом? Оружие? Солдат? Солдатские командиры? Корпорация, которая сделала это оружие?

Неправительственные организации и эксперты в области международного права опасаются, что автономная оружие приведет к серьезной бреши в подотчетности.

Юридическая и моральная проблема не облегчается перекладыванием вины вверх по цепочке командования или обратно на место производства. В мире, где нет правил, предписывающих осмысленный контроль человека над автономным оружием, будут совершаться военные преступления без привлечения военных преступников к ответственности. Структура законов войны будет значительно ослаблена.

Новая глобальная гонка вооружений

Представьте себе мир, в котором военные, повстанческие группировки, международные и внутренние террористы могут применять теоретически неограниченную смертоносную силу при теоретически нулевом риске и без какой-либо юридической ответственности.

Это мир, где неизбежны алгоритмические ошибки, от которых страдают даже такие технологические гиганты, как Amazon и Google, теперь могут привести к уничтожению целых городов.

По материалам: The Conversation