Бесплатное приложение от iFixit, организации, специализирующейся на ремонте и отстаивании права на ремонт, имеет одну чрезвычайно полезную функцию для любой модели смартфона. Он показывает персонализированную ориентировочную дату, когда стоит заменить аккумулятор, задолго до того, как он начнет серьезно ухудшаться.

Это работает как аналог индикатора неисправности для той части телефона, которая вероятнее всего выйдет из строя первой. Приложение доступно для iPhone и Android.

Эта возможность iFixit значительно более информативна, чем нечеткие показатели “работоспособности” батареи, встроенные в настройки некоторых свежих смартфонов. Приложение также имеет удобный чат-бот на основе искусственного интеллекта.

iFixit представлен следующим образом: это независимая организация, которая занимается ремонтом, правом на ремонт и созданием открытых руководств по восстановлению электроники, а также предлагает инструменты и запчасти для самостоятельного ремонта.

Пример iFixit демонстрирует, что действительно полезные технологии не всегда создаются крупными корпорациями. Организации, которые глубоко понимают потребности пользователей, способны предлагать не менее эффективные приложения и инструменты.

Своевременная и доступная замена аккумулятора помогает избежать необходимости покупать новый телефон. Однако определить момент, когда эта замена должна произойти, обычно невозможно, пока проблема не станет очевидной.

Встроенные функции оценки состояния аккумулятора в большинстве смартфонов не дают полезной информации. Смартфон может показывать, что текущая емкость составляет 94 процента от номинальной. Однако без объяснения, когда именно начнется резкое падение автономности. Обычно значительное снижение наблюдается после падения емкости до уровня примерно 80 процентов, но настройки не сообщают вам, насколько быстро этот предел будет достигнут.

В других устройствах информация может быть еще менее подробной или подаваться в виде двоичного состояния: аккумулятор исправен или неисправен.

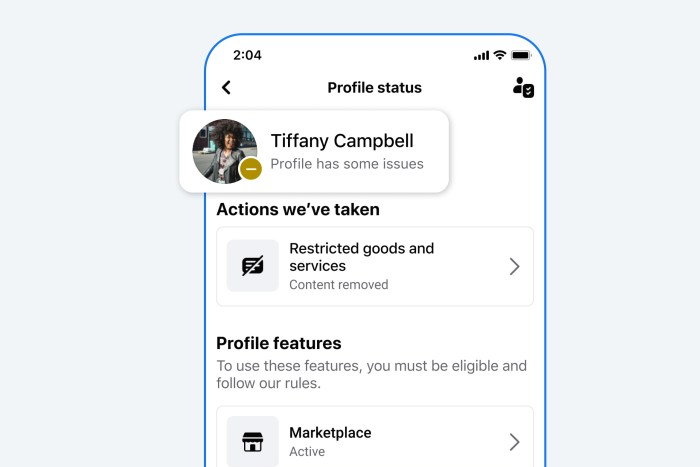

Приложение iFixit предоставляет более практичные данные. Он показывает состояние батареи: хорошее, удовлетворительное или неудовлетворительное. Кроме того, отмечается прогнозируемый месяц и год, когда аккумулятор, вероятно, достигнет уровня износа, при котором его стоит заменить. Приложение также может посоветовать местную ремонтную мастерскую из перечня проверенных партнеров. Дополнительно доступны ссылки на инструкции по замене и запасные части, если пользователь планирует выполнить ремонт самостоятельно.

Разработчики отмечают, что производители смартфонов не всегда делают такие данные легко доступными. Для пользователей iPhone приложение содержит инструкцию по необходимым изменениям в настройках, чтобы предоставить доступ к нужным данным.

Можно встретить мнение, что производители не заинтересованы в упрощении процедуры замены батареи, поскольку это уменьшает количество покупок новых устройств.

Некоторые пользователи пытаются продлить срок службы батареи, поддерживая заряд в диапазоне от 20 до 80 процентов. Однако достаточно избегать экстремальных температур, включать адаптивную зарядку, если она доступна.

Дополнительный инструмент на основе искусственного интеллекта

Кроме функции прогнозирования состояния аккумулятора приложение iFixit предлагает инструмент на основе искусственного интеллекта, который помогает диагностировать проблемы с электроникой и бытовой техникой и предлагает соответствующие материалы и инструкции по ремонту.

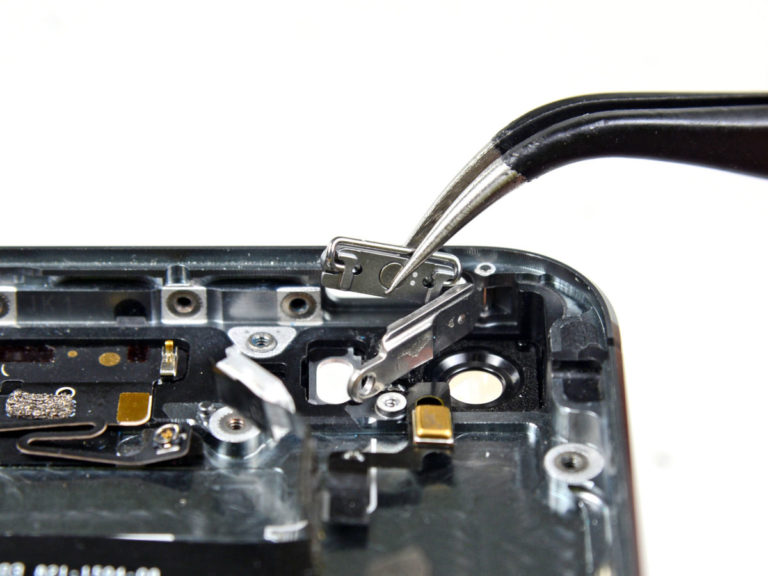

В приложении можно сделать фотографию устройства и получить советы по решению проблемы. Инструмент также предоставляет ссылки на качественные заменяемые детали, доступные в каталоге iFixit.

По словам представителей организации, FixBot работает точнее, чем универсальные чат-боты, потому что он основан на обширной библиотеке инструкций и сервисных материалов, которые iFixit собирает на протяжении десятилетий. Подтвердить это утверждение независимо пока невозможно.

Чат-бот iFixit в настоящее время доступен бесплатно, однако, по словам генерального директора iFixit Кайла Виенса, стоимость поддержки искусственного интеллекта значительна, поэтому отдельные функции станут платными в будущем.