Специалисты по психическому здоровью все чаще бьют тревогу из-за случаев, когда пользователи чат-ботов на основе искусственного интеллекта оказываются в тяжелых психических кризисах с паранойей и бредом. Эту тенденцию уже начали называть «ИИ-психоз».

Научный сотрудник и психиатр Калифорнийского университета в Сан-Франциско Кит Саката сообщил в социальных сетях, что лично видел по меньшей мере двенадцать госпитализаций из-за того, что люди «потеряли связь с реальностью из-за ИИ».

Саката объяснил, что психоз-это состояние, при котором человек разрывает связь с «общей реальностью». Он может проявляться в виде фиксированных ложных убеждений (заблуждений), зрительных или слуховых галлюцинаций, а также дезорганизованного мышления. Наш мозг работает по принципу прогнозирования: мы формируем предположения о реальности, проверяем их, а затем обновляем убеждения в соответствии с фактами. Психоз, по словам исследователя, возникает, когда этап «обновления» дает сбой. И именно в эту уязвимость, считает Саката, легко» проскальзывают » чат-боты на базе больших языковых моделей, таких как ChatGPT .

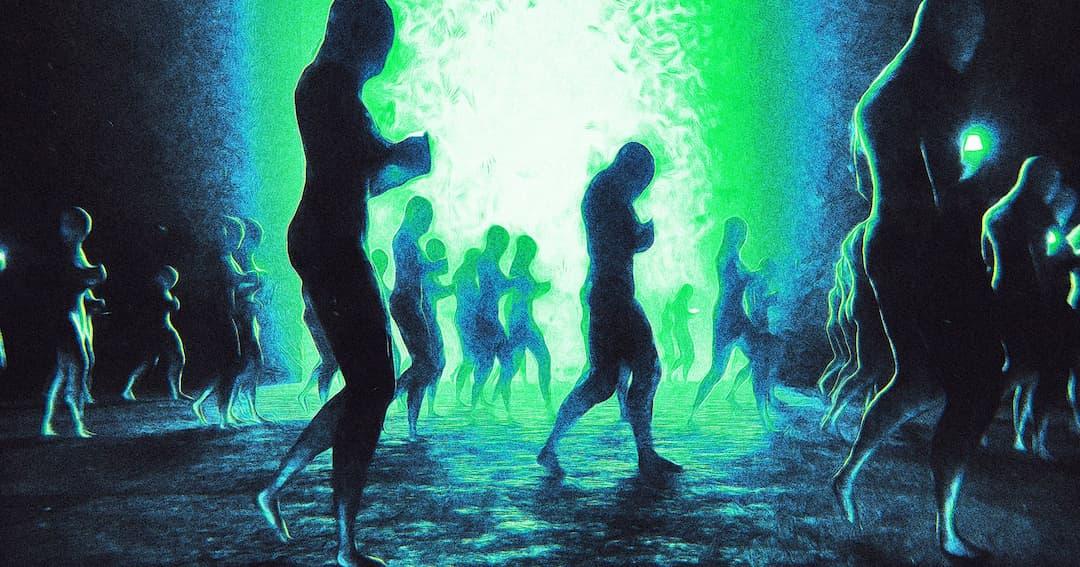

Он сравнил ИИ-чат-ботов с»галлюцинаторным зеркалом». Такие системы работают, предсказывая следующее слово на основе данных обучения, подкрепления и реакции пользователей. Поскольку они оптимизированы для привлечения и удовлетворения пользователя, они часто чрезмерно соглашаются с ним и подтверждают его мнения, даже когда они ошибочны или вредны. Это может приводить к замкнутым повторяющимся взаимодействиям, в которых модель многократно подкрепляет бред, независимо от их соответствия реальности или последствий для пользователя.

Подобные сценарии уже приводили к тяжелым психологическим кризисам, которые, зафиксировано, заканчивались разводами, бездомностью, принудительным лечением, заключением и даже смертью.

В начале августа OpenAI признала, что ChatGPT иногда «не распознавал признаки бреда или эмоциональной зависимости» у пользователей. Компания заявила о привлечении экспертов для изучения проблемы и добавила уведомление о продолжительности сеанса, однако журналисты обнаружили, что бот все еще пропускает явные признаки психического кризиса.

Саката подчеркивает, что ИИ обычно является лишь одним из факторов, предшествующих психотическому эпизоду, наряду с потерей сна, наркотиками или аффективными расстройствами. «ИИ-это спусковой крючок, но не само оружие», — пишет он. Однако, по его мнению, все мы уязвимы, ведь те самые качества, которые делают людей гениальными — интуиция и абстрактное мышление-могут толкнуть нас к психологическому срыву.

Дополнительный риск заключается в том, что постоянная проверка ИИ более приятна и удобна, чем напряженность и конфликты реальных отношений. Многие пользователи попадают в бредовые сценарии, где им внушают, что они «особенные» или «избранные». В сочетании с личными кризисами, горем, хроническим стрессом и эффектом Элизы это создает опасный коктейль.

«Скоро ИИ-агенты будут знать вас лучше, чем друзья. Но будут ли они говорить неприятную правду или и дальше поддакивать, чтобы вы не ушли?»- спрашивает Саката. И добавляет, что технологические компании стоят перед жестким выбором: удерживать пользователей ценой подкрепления ложных убеждений или же рисковать их потерять.