Дослідники Стенфордського університету заплатили 1,052 людям по 60 доларів, щоб вони прочитали перші два рядки з книги «Великий Гетсбі» у спеціальному додатку. Після цього ШІ, який виглядав як 2D-аватар із гри епохи SNES, попросив учасників розповісти історію свого життя. Вчені використали ці інтерв’ю, щоб створити ШІ, який, за їх словами, імітує поведінку учасників із точністю 85%.

Як працює технологія створення “ШІ-клону”?

Дослідження під назвою “Генеративні агентні симуляції 1,000 людей” є спільним проектом Стенфорда та дослідницької лабораторії Google DeepMind. Метою є створення ШІ-агентів, які могли б допомогти політикам та бізнесменам краще розуміти суспільство. Навіщо використовувати фокус-групи чи опитування, якщо можна провести одну розмову, створити ШІ-модель на її основі та мати її думки й погляди назавжди? Або принаймні їхню максимально близьку до реальності імітацію.

«Ця робота закладає основу для нових інструментів, які можуть допомогти досліджувати індивідуальну та колективну поведінку», — зазначається в анотації до роботи.

«Як, наприклад, може реагувати різноманітна група людей на нові політики у сфері охорони здоров’я, запуск продуктів чи великі кризи? Коли симульовані індивіди об’єднуються в колективи, такі симуляції можуть допомогти розробляти заходи, створювати складні теорії, які враховують причинно-наслідкові та контекстуальні взаємодії, а також розширювати наше розуміння таких структур, як інститути й мережі в економіці, соціології, організаціях і політичних науках», — продовжує текст.

Усі ці можливості базуються на двогодинному інтерв’ю, яке передається до великої мовної моделі (LLM), що здебільшого відповідає так само, як і її реальні прототипи.

Результати та ризики використання

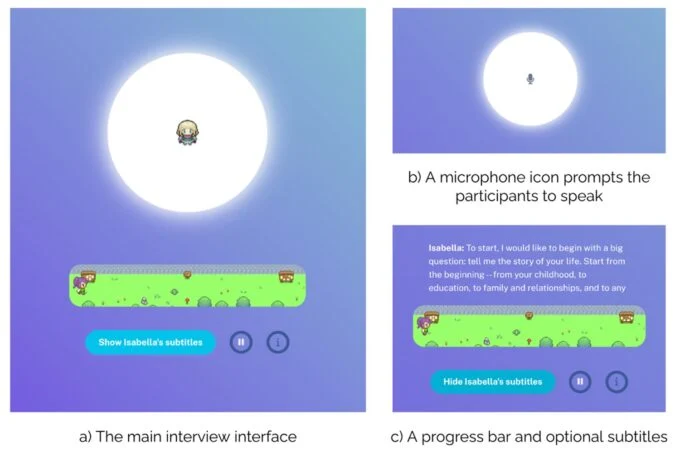

Більшість процесів було автоматизовано. Дослідники залучили компанію Bovitz, яка спеціалізується на маркетингових дослідженнях, щоб знайти учасників. Метою було отримати максимально широке представництво населення США в межах 1,000 людей. Для участі в експерименті користувачі створювали акаунти в спеціально розробленому інтерфейсі, створювали 2D-аватари й починали розмову з ШІ-інтерв’юером.

Питання та стиль інтерв’ю адаптовано зі схеми, розробленої проектом American Voices Project — спільної ініціативи Стенфорда й Принстонського університету.

Кожне інтерв’ю починалося з того, що учасники читали перші два рядки з «Великого Гетсбі» («У молоді й більш вразливі роки мій батько дав мені пораду, яку я з тих пір не раз обмірковував. “Коли захочеш когось критикувати, — сказав він, — пам’ятай, що не всі у світі мали такі переваги, як ти”»), щоб відкалібрувати аудіо.

Двогодинні інтерв’ю в середньому створювали стенограми обсягом 6,491 слово. Учасників запитували про расу, стать, політичні погляди, рівень доходу, використання соціальних мереж, робочий стрес і сімейний стан. У дослідженні також опубліковано сценарій інтерв’ю та питання, які ставив ШІ.

Ці стенограми, менші за 10,000 слів кожна, були передані в LLM, яку дослідники використовували для створення генеративних агентів, що імітують учасників. Потім дослідники перевіряли як учасників, так і їхні ШІ-клони через додаткові питання та економічні ігри. «Коли агенту ставиться запитання, вся стенограма інтерв’ю додається до запиту в моделі, інструктуючи модель імітувати людину на основі даних її інтерв’ю», — йдеться у дослідженні.

Цей етап був максимально контрольованим. Дослідники використовували General Social Survey (GSS) та Big Five Personality Inventory (BFI), щоб перевірити, наскільки ШІ відповідає своїм прототипам. Потім учасники та їхні ШІ-клони брали участь у п’яти економічних іграх.

Результати виявилися змішаними. ШІ-агенти відповідали приблизно на 85% питань так само, як і реальні учасники, у тесті GSS і на 80% у тесті BFI. Однак у економічних іграх результати були гіршими. Наприклад, у грі «Дилема в’язня», де учасники могли співпрацювати або обманути свого партнера, чи в «Грі диктатора», де потрібно було розподілити ресурси, ШІ не завжди діяв так само, як реальні люди. «У середньому генеративні агенти досягли нормалізованої кореляції 0,66», тобто приблизно 60%.

Ця робота демонструє, наскільки швидко можна створити ШІ, що імітує людську особистість. Але це також викликає побоювання, адже подібна технологія може використовуватися у зловмисних цілях. Вже були випадки, коли менш розвинені мовні моделі обманювали людей, змушуючи їх віддавати гроші. Що станеться, якщо такі системи отримають доступ до більш деталізованих особистостей, створених на основі соціальних мереж чи інших відкритих даних?