В 2016 году мы писали то, что публично стала доступна технология «фотошопа для аудио», которая легко позволит сказать что угодно голосом желаемого человека. Точность работы такой технологии почти идеальная, и недавно киберэксперты раскрыли новую схему мошенничества с ее использованием. Злоумышленники имитируют голоса директоров и топ-менеджеров компаний, приказывая рабочим выдать им личные данные клиентов, деньги с корпоративного счета и тому подобное.

Специалисты Symantec сообщили о трех случаях, в которых мошенники подделывали голос директора компании и заставляли финансовый отдел переводить деньги на свои счета.

Эксперты из кибербезопасности говорят, что нейросеть для имитации голоса можно натренировать, если иметь большой объем оригинального контента. Получить его не сложно, ведь это могут быть публичные выступления, записи интервью, корпоративные видео и тому подобное. Хотя тренировки нейросети для получения качественного фальшивого голоса требуют много времени и тысячи долларов, это выгодно с финансовой точки зрения.

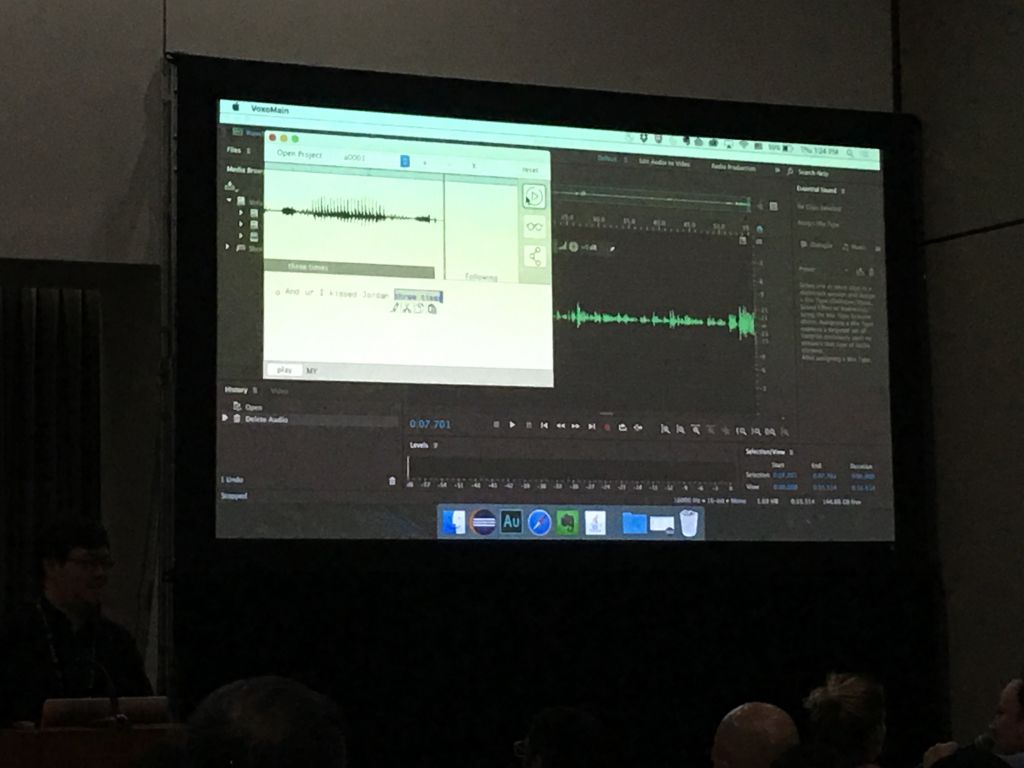

В создании фальшивого голоса участвуют две нейросети, которым «скармливают» десятки часов оригинального контента. Далее искусственный интеллект использует аудио для тренинга двух так называемых «генеративных соревновательных сетей» (GAN). В процессе обучения две нейросети такого типа «конкурируют» между собой: одна генерирует подделки, другая пытается отличить подделку от подлинного образца данных, и в процессе обе сети учатся на своих ошибках.

Полученный после обучения искусственный интеллект почти идеально копирует речь человека-жертвы, включая ритм и особенности произношения. Дополнительно мошенники маскируют мелкие особенности произношения слогов и слов в наименее убедительных местах с помощью специфических шумов. Для таких целей используется имитация прерывистой сотовой связи или фоновый шум в оживленном людном месте.

По мнению специалистов Symantec, руководителям компаний нужно серьезно проанализировать доступный в публичном пространстве контент с их участием. Ведь злоумышленники могут получить необходимые образцы голоса даже в телефонной беседе или в личной беседе.

Кстати, подделывать можно не только аудио – нейросети позволяют почти с идеальным качеством заменять лица на видео.